- Опубликовано:14.07.2025

- Комментарии:

1 Комментарий - Рубрика:

Оптимизация - Просмотров: 220

Иногда возникает необходимость закрыть от индексации страницы, в адресах которых находится запятая. И возникает вопрос, можно ли использовать в командах роботс данный символ?

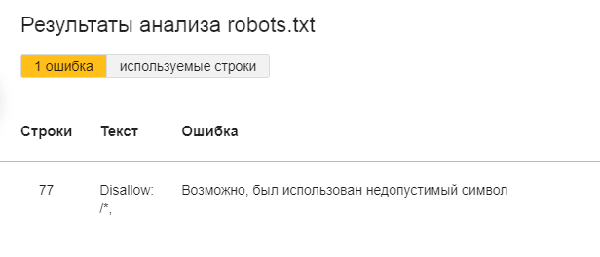

Например, закрыть все страницы с запятыми от индексации командой Disallow: /*,?

Если попытаться так сделать и проверить файл robots.txt в Яндекс.Вебмастере, то появится уведомление об ошибке «Возможно, был использован недопустимый символ»:

Так будет или нет работать такая команда в Яндексе? Мы решили уточнить этот вопрос в поддержке поисковой системы, и вот что нам ответили:

«Я вижу, что указанная вами директива работает корректно. Она является нетипичной, поэтому Вебмастер отображает предупреждение. Вы можете не обращать на него внимание. Страницы, которые вы присылали ранее, в поиске уже не участвуют».

Таким образом, использовать символ запятой в файле robots.txt можно, и данные команды будут обработаны Яндексом.

Ошибки в этом случае не будет, а уведомление при проверке файла роботс.тхт в Вебмастере выводится из-за того, что такая команда является нетипичной, и не более того.

Читайте также:

1 Ответ

Интересная ситуация, я тоже год назад пытался закрыть всякий мусор на своем сайте с помощью роботса, но у меня не было мусорных страниц с запятой в адресе. Теперь буду знать, что их тоже можно закрыть через robots.txt и Яндекс будет норм это обрабатывать.